Podemos definir la inteligencia artificial de una manera amplia, como un conjunto de ideas y técnicas que normalmente requieren de la inteligencia humana, pero que gracias a los avances de la tecnología también pueden ser ejecutadas por sistemas computacionales (Beckett, 2019: 12).

Dentro de este campo, resulta de especial interés la IA generativa (GenAI), que incluye aquellos sistemas capaces de generar nuevos datos a partir de otros existentes. Esta generación de nuevos elementos se logra gracias a otro subcampo de la disciplina, el Machine Learning (ML), que utiliza una serie de algoritmos y modelos estadísticos para analizar y reconocer patrones en los datos previos, tomando así nuevas decisiones basadas en sus descubrimientos. De esta manera, los ordenadores adquieren la habilidad de aprender automáticamente por ellos mismos, permitiendo el desarrollo de tareas para las que no fueron programadas explícitamente (Expert.ai, 2022).

Este concepto está intrínsecamente relacionado con otros como el Deep Learning y sus redes neuronales, ya que estas tecnologías están diseñadas para emular la estructura y el funcionamiento del cerebro humano, especialmente en sus procesos de aprendizaje.

Todo ello da origen a una rama específica de la IA, el Procesamiento del Lenguaje Natural (PLN), que permite a las máquinas leer, entender, interpretar y generar lenguaje humano, facilitando una interacción más natural entre personas y máquinas (Education Ecosystem, 2018), sin la necesidad de utilizar código o lenguaje de programación específico.

Esta tecnología ya potenciaba traductores como Google Translate o DeepL, correctores como Grammarly, o asistentes personales como Siri y Alexa. Sin embargo, ha recibido un notable impulso con el crecimiento de los nuevos Modelos de Lenguaje a Gran Escala —Language Large Models (LLM)— como ChatGPT, un modelo desarrollado por la compañía OpenAI mediante la arquitectura GPT (Generative Pre-trained Transformer).

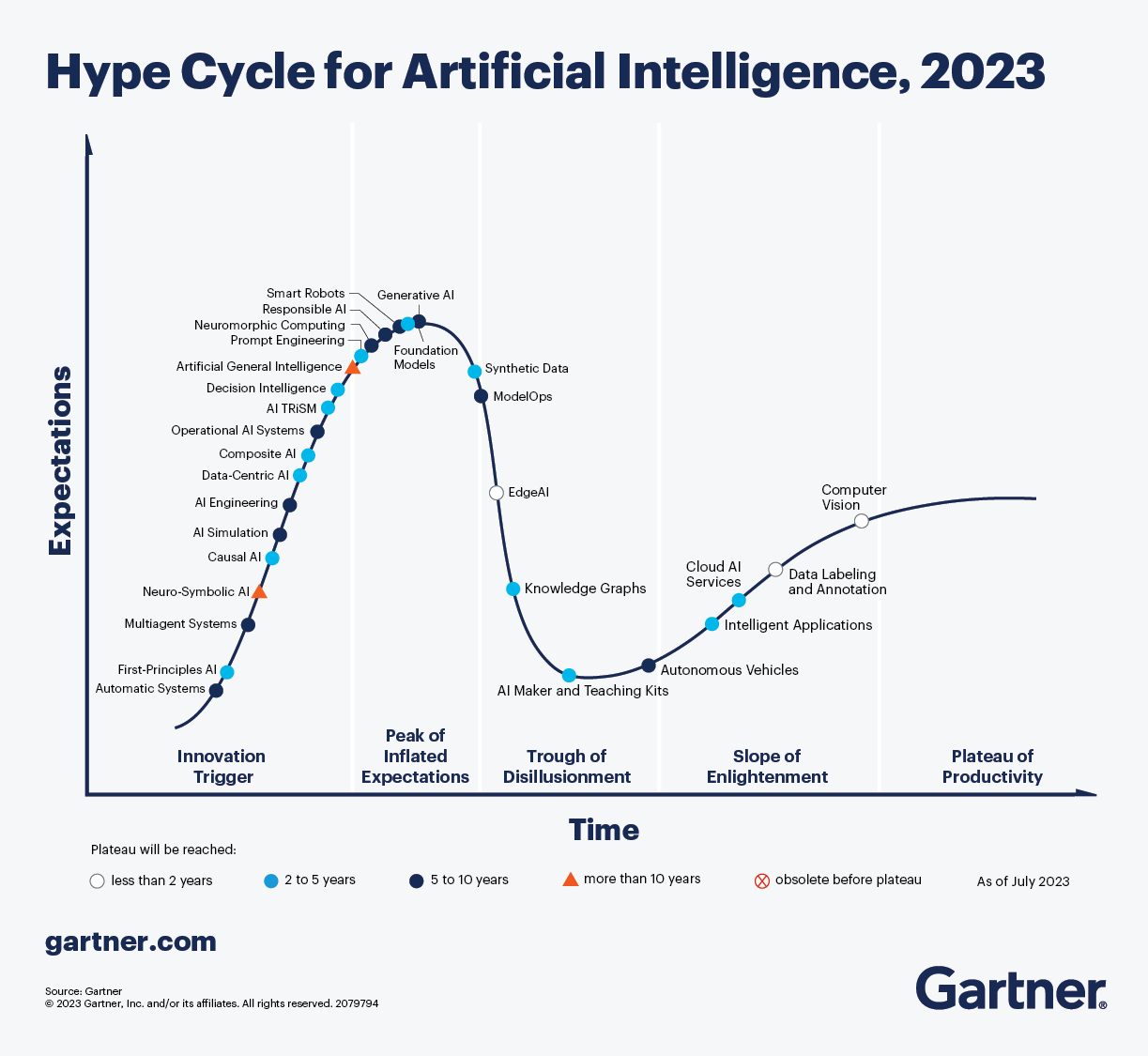

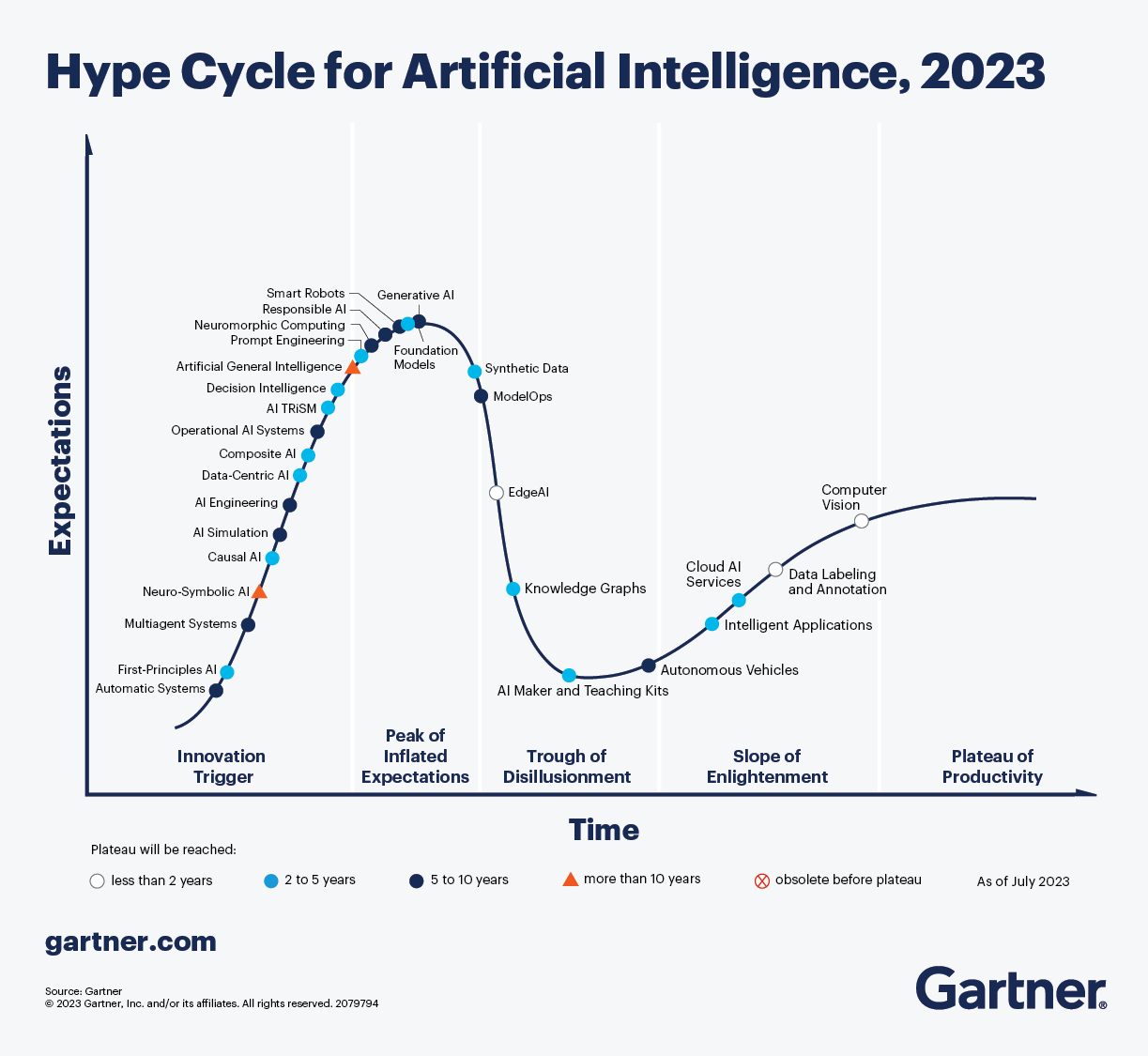

Para comprender este fenómeno, es conveniente revisarlo con perspectiva mediante el modelo de Hype Cycle de Gadner que representa las expectativas de una tecnología y la adopción real de la misma (en forma de curva). En el caso de la IA (generativa), estamos en el mayor punto de hiperinflación de expectativas.

Hype Cycle for Artificial Intelligence (2023)

Hype Cycle for Artificial Intelligence (2023)

Fuente: https://www.gartner.com/en/articles/what-s-new-in-artificial-intelligence-from-the-2023-gartner-hype-cycle

¿Es sólo una moda? ¿O es realmente un cambio de tendencia en la forma de relacionarnos con la información y en los procesos creativos?