Más allá de las aplicaciones textuales, la IA se expande hacia otros muchos sectores (Gozalo-Brizuela y Garrido-Merchán, 2023). Los generadores de texto a imagen como Midjourney, Dall-E o Stable Diffusion quizá son los más populares, pero la generación de vídeo también avanza con increíble rapidez a través de herramientas como Gen-2 de Runway. Otras como Mirage o Vid2Avatar permiten convertir texto o vídeo directamente a modelado 3D.

Poco a poco comienzan a perfeccionarse otras herramientas de generación de música y audio, donde algunas permiten la clonación de voces humanas. Esto, junto a los avances en generación de vídeo, permite la creación de avatares digitales basados en personas reales —algo en lo que se especializan herramientas como Spiritme—, o incluso traducir nuestros discursos a otros idiomas con nuestra misma —donde destacan aplicaciones como ElevenLabs y Rask.

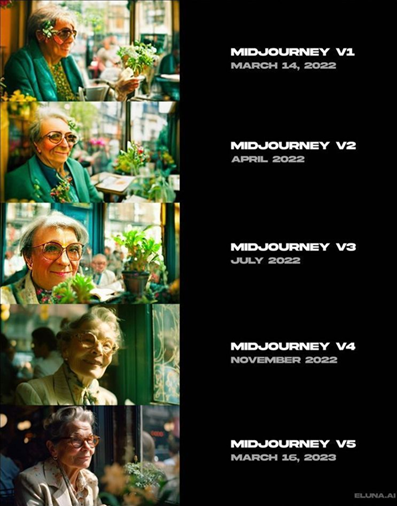

Evolución de Midjourney a lo largo de sus versiones. El perfeccionamiento del modelo en tan solo un año es impresionante, y muchos apuntan a que ocurrirá lo mismo con la generación de vídeo

Evolución de Midjourney a lo largo de sus versiones. El perfeccionamiento del modelo en tan solo un año es impresionante, y muchos apuntan a que ocurrirá lo mismo con la generación de vídeo

Fuente: Eluna.ai

Además de la generación, muchos modelos comienzan a especializarse en la edición del propio contenido. Aquí podemos hablar de las técnicas de inpainting y outpainting en Stable Diffusion, que permiten modificar o ampliar los elementos de una imagen. De igual forma, pueden obtenerse importantes mejoras en la resolución de las imágenes a través de aplicaciones como Topaz. Otras, como Wonder Studio, permitirán grandes avances en transformaciones video-to-video.

Todo apunta a que en el futuro encontraremos numerosos modelos multimodales, capaces de ejecutar tareas de distinto tipo, algo a lo que ya tienen acceso los suscriptores de GPT-4, tanto de forma nativa como a través de plugins. Estas extensiones permiten a ChatGPT interactuar con otras aplicaciones —por ejemplo, para realizar compras en ciertas tiendas, crear nuevos archivos en PDF, o diseñar diagramas editables directamente en aplicaciones como Miro.

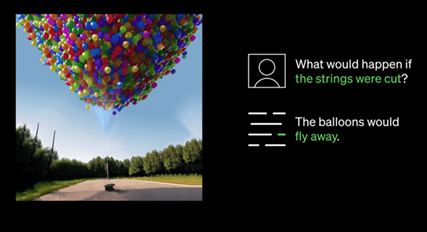

Ejemplo de integración de la multimodalidad en GPT-4: no solo es capaz de entender y producir texto, sino que también tiene "visión" y puede entender el contenido de la imagen

Ejemplo de integración de la multimodalidad en GPT-4: no solo es capaz de entender y producir texto, sino que también tiene "visión" y puede entender el contenido de la imagen

Fuente: OpenAI (2023)

Muchos de estos modelos se integrarán en nuestras aplicaciones de uso cotidiano, algo que ya podemos ver con las nuevas actualizaciones de Canva con su Magic Studio, o el Copilot de Microsoft integrado en el navegador Edge, las aplicaciones de ofimática de Microsoft 365 y todo el ecosistema de Windows.

También es posible que lleguen a popularizarse las herramientas de auto-prompting, como AutoGPT, capaces de dividir un objetivo amplio en tareas más pequeñas para ir ejecutándolas de forma autónoma hasta conseguir sus instrucciones iniciales.